par Sofia Smyej

Contrairement à ce que l’on pourrait croire, l’Intelligence Artificielle n’a d’artificielle que le nom. Le comportement de la machine relève bien des choix conscients ou inconscients de ses programmeurs.

L’IA est devenue le défi industriel de cette décennie. Elle se déploie progressivement et assez discrètement dans de nombreux services à traitement de données, quels qu’ils soient: la détection sécuritaire, l’aide au diagnostic médical, la finance, la mise en place de politiques publiques, la sélection dans les universités, les assistants numériques des GAFAMs, tout ce qui nécessite de détecter des informations particulières, de les analyser, dans le but de générer un fonctionnement automatisé pouvant remplacer l’humain. L’IA peut travailler 24/24 et ne coûte rien en charges sociales.

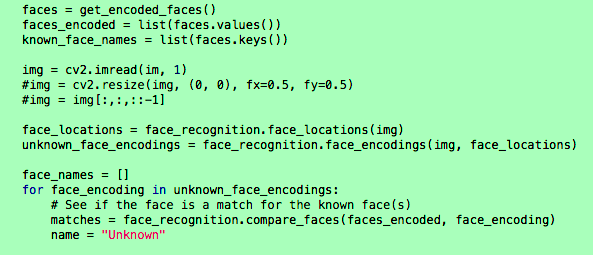

Au cœur de ces systèmes, les algorithmes, des fonctions mathématiques et sémantiques destinées à fouiller, identifier les données, trier, classer et, en bout de chaîne, des systèmes de décision, capables éventuellement d’opérer des choix ou d’effectuer des tâches diverses. Les algorithmes permettent de déléguer la prise de décision à une machine.

Ce qui pourrait apparaître totalement neutre, avec des choix objectifs opérés par une machine non pensante, est en fait lié à la nature subjective de l’algorithme, intimement dessinée par son programmeur, sous le cahier des charges du commanditaire. Deux visions qui peuvent influer fortement sur les résultats. En effet, ces algorithmes opèrent sous la forme de successions et d’associations de choix simples. Ces choix sont directement liés aux valeurs politiques, morales ou sociétales du programmeur. C’est ainsi que des décisions automatisées, appliquées aux humains, peuvent montrer des biais en tout genre, par exemple, racistes, misogynes ou classistes. Ces biais ne sont pas forcément issus d’intentions malveillantes des programmeurs mais relèvent aussi de choix inconscients.

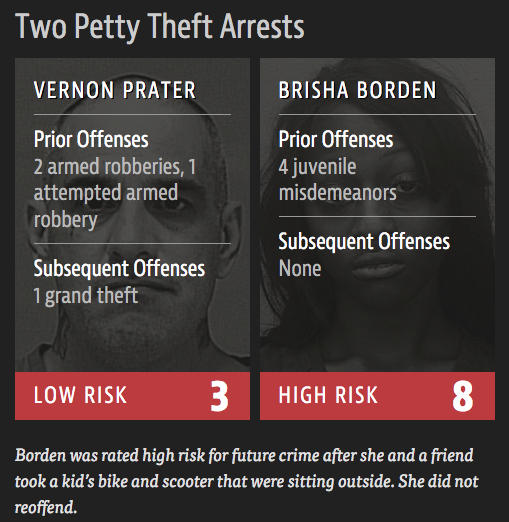

Plusieurs affaires récentes ont mis en lumière ce genre de biais, notamment dans le domaine de la sécurité. Certaines villes États-Uniennes tentent de faire de l’analyse prédictive de crimes avec des des IA. D’autres tentent de déterminer le taux de récidive pour influer sur la prise de décision des juges. Après plusieurs années d’utilisation, un constat édifiant est apparu: en Floride, une étude universitaire indépendante, menée sur un système de détection de taux possible de récidive, le module COMPAS, a montré qu’il s’orientait majoritairement vers des hommes pauvres et racisés. L’algorithme inclut la couleur de peau comme facteur de récidivité: les hommes noirs sont donc défavorisés vis à vis des hommes blancs. Cet algorithme a des conséquences concrètes puisque les juges, s’appuyant sur le taux de récidivité, justifient leur sanctions par ces outils : le prisonnier va t-il subir une détention provisoire, un bracelet électronique, ou sa peine va t-elle être allégée ? Dans ce cas précis, nulle commission n’avait analysé les algorithmes avant de mettre en place le système, la justice se fiant uniquement au travail des développeurs, et au marketing de l’entreprise vendant le logiciel. Quelles autorités, quelles procédures, quelles régulations auraient pu prévenir les biais de ce système ?

Les conséquences de biais dans un traitement massif de données par les IA pèsent sur l’ensemble de la société, on le voit tous les jours avec l’influence des algorithmes des réseaux sociaux sur la planète entière. Les GAFAMs sont devenus omniprésents. Leur influence économique, politique ou psychologique est maintenant bien analysée par des milliers d’études. Mais la population commence à peine à en découvrir leur pouvoir de nuisance, notamment à la suite de grands scandales comme l’affaire Cambridge Analytica, une des entreprises qui permettent des manipulations politiques de millions de votants, par les réseaux sociaux, à diverses élections dans le monde entier. Cette découverte reste encore lacunaire, peu de citoyens étant capables de comprendre la complexité du neuromarketing et de la manipulation mentale par des algorithmes.

En effet, les caractéristiques des algorithmes sont rarement publiques, ce sont des secrets industriels. Mais leur impact sur la société est tel que cette opacité questionne les bases des systèmes démocratiques. En France, le rapport de Cédric Villani et son équipe cherche à définir ce que seraient “une IA sensée” : “accroître la transparence et l’auditabilité des systèmes autonomes … en développant les capacités nécessaires pour observer, comprendre et auditer leur fonctionnement” au travers d’”un corps d’experts dotés des compétences requises”.

Qui a le droit de regard sur ces algorithmes et le décisionnel associé ? Comment en identifier leurs éventuelles orientations politiques, raciales, religieuses ou de genre ? Sur quelles bases juridiques permettre à un comité d’éthique de statuer sur la viabilité démocratique et sociétale de ces algorithmes ? Analyser et comprendre l’impact qu’ont ces algorithmes dans la vie quotidienne devient donc indispensable.

En France, la CNIL développe une série de réflexions sur le sujet depuis une dizaine d’années, sans que ce sujet soit réellement étudié et pris au sérieux par le champ politique ou par le grand public. Nous réagissons au cas par cas. Les États-Unis mènent la danse de l’innovation depuis près de 20 ans, sans aucune régulation à priori. On applique d’abord, on mesure les conséquences ensuite. Le marché est tellement fluctuant, l’innovation est tellement susceptible de générer des revenus énormes en des temps très courts, qu’aucun mécanisme préventif ne peut opérer.

En fait, bien que la CNIL puisse saisir la justice pour non respect des droits fondamentaux, notamment en matière d’exploitation des données, il en reste que les GAFAMs, premiers profiteurs de l’exploitation des données, peuvent se permettre de ne pas se soumettre au droit français et européen, la RGPD notamment, et ce pour diverses raisons. D’abord, si un problème se révèle et si une action judiciaire peut être tentée, ce qui prend déja un temps considérable, la machine juridique sera lente, et si des sanctions financières finissent par aboutir, elles ne seront pas assez limitantes face à des transnationales qui brassent des centaines de milliards de dollars. Ensuite, l’évolution des algorithmes est tellement rapide, et peut se disperser à l’échelle de la planète en quelques clics, qu’aucune loi, aucun mécanisme de prévention ne peut opérer en des temps si courts. Nous sommes véritablement à l’époque du Far Ouest numérique, où tous les coups sont permis jusqu’à l’arrivée de la cavalerie.

Ainsi le juriste Désiré Allechi, spécialisé en droit TIC, explique qu’il est difficile de contrer les GAFAMS au travers du levier juridique actuel. Il s’exprime : “personnellement pessimiste quant au caractère dissuasif ou intimidant du montant des sanctions pécuniaires pour les GAFAM, je pense que l’une des solutions efficaces serait la « consommation locale » des produits (smartphones et outils technologiques susceptibles de contenir des données personnelles) et services, Il est donc possible et les moyens pour le faire ne manquent pas, de privilégier les services similaires de plateformes garantissant le respect des droits et les libertés fondamentaux”.

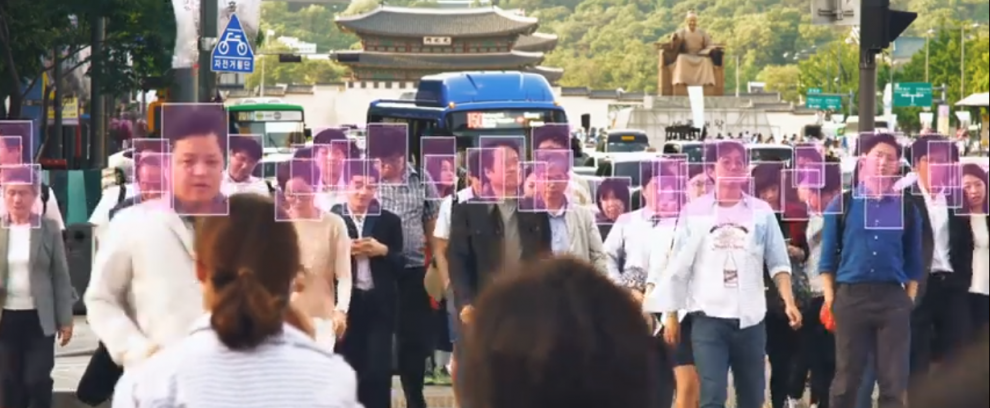

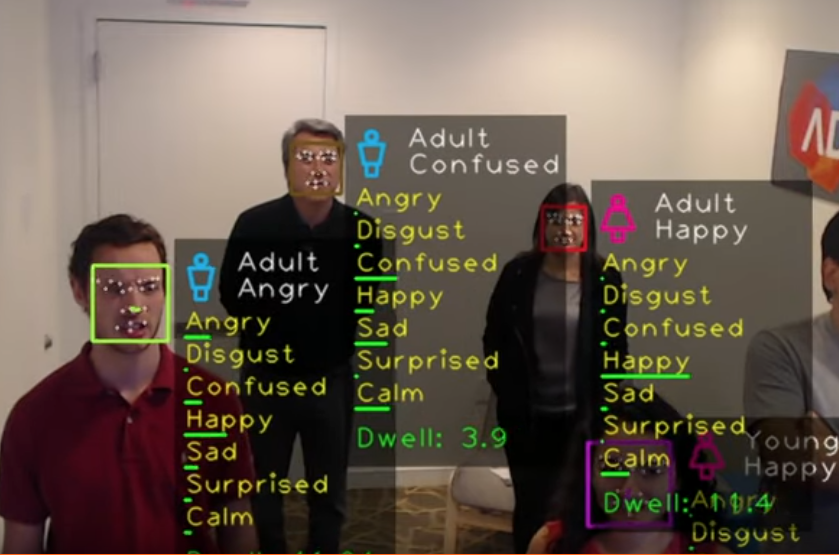

Lorsque les technologies numériques sont aussi englobantes que celles des GAFAM, le manque de souveraineté technologique devient problématique pour l’ensemble de notre vie. Il en va de nos activités économiques et sociétales, mais aussi de nos activités politiques, au point où nous pouvons légitimement interroger la survie-même de la démocratie. Nous citoyens, sommes actuellement massivement observés, analysés, manipulés, dépendants d’algorithmes dont la nature, voire l’existence nous échappe. Nous sommes impuissants devant les forces mises en place, notamment celles liées à la sécurité, qui peuvent directement s’attaquer à des libertés fondamentales.

Pire, des expériences récentes, comme par exemple la détection des émotions dans le tram à Nice, la détection de comportement en Chine ou en Israël, montrent que les populations sont prêtes à perdre des pans entiers de leurs libertés pour une illusion de sécurité. Mais ces technologies sont discrètes. On ne s’étonne pas que le grand public soit aussi ignorant des enjeux de la souveraineté technologique. Dans les médias, ces problématiques sont toujours reléguées à la rubrique Technologies, alors qu’il s’agit de véritables problèmes politiques, de véritables problèmes de société. Il reste un énorme travail d’information et de vulgarisation à faire.

En attendant que les forces politiques, médiatiques et éducatives s’emparent des problématiques de la souveraineté technologique, et les traitent par des mesures adaptées, nous sommes collectivement désarmés. A l’échelle collective, le combat est perdu d’avance devant le nombre de fronts à mener. Cependant, à l’échelle du citoyen, il est possible, par un comportement numérique et social adapté, dans une véritable transition numérique, individuelle, de se soustraire à certains canaux d’observation ou de manipulation. A suivre…

Catégorie : Non classé